При создании сайта важно помнить, что не всегда требуется, чтобы содержимое сайта было общедоступным. Иногда для определенных целей необходимо ограничить доступ к сайту для обычных поисковых систем. Например, при создании сайта-заглушки для проведения работ или при необходимости создания внутреннего сайта, предназначенного только для определенной аудитории.

Есть несколько способов закрыть сайт от индексации и отображения в результатах поиска. Один из самых распространенных методов — использование файла robots.txt. Этот текстовый файл находится в корневой директории сайта и содержит инструкции для поисковых систем. С помощью правильной настройки файла robots.txt можно запретить доступ поисковым роботам к определенным страницам или целиком запретить индексацию всего сайта.

Еще один метод — использование мета-тега «noindex» на нужных страницах. Этот тег указывает поисковым системам не индексировать содержимое страницы. Но следует учесть, что установка мета-тега «noindex» на страницу не гарантирует ее полное скрытие от поисковых систем, так как некоторые поисковые системы могут отображать страницу в результатах поиска, но без ее содержимого.

Правила игры в прятки: как закрыть сайт от индексации и отображения в результатах поиска

Одним из наиболее эффективных способов является использование файла robots.txt. Этот файл размещается на сервере и содержит инструкции для поисковых ботов о том, как индексировать и отображать страницы сайта. С помощью файла robots.txt можно указать поисковым системам, что сайт должен быть полностью или частично закрыт от индексации.

Для того чтобы закрыть сайт полностью, можно добавить следующую инструкцию в файл robots.txt:

- User-agent: * — означает, что инструкции будут применяться ко всем поисковым ботам;

- Disallow: / — запрещает индексацию всех страниц сайта.

Также есть возможность закрыть от индексации отдельные разделы сайта. Для этого нужно указать путь к конкретному разделу в директиве Disallow. Например:

- Disallow: /admin/ — запрещает индексацию раздела «admin» сайта.

Важно помнить, что файл robots.txt не является абсолютной защитой от индексации. Некоторые поисковые системы могут игнорировать его инструкции, а также злонамеренные пользователи могут проигнорировать правила доступа к файлу. Поэтому, помимо использования robots.txt, рекомендуется принять и другие меры для обеспечения безопасности и конфиденциальности.

Зачем закрывать сайт от индексации и отображения в результатах поиска

Для различных владельцев сайтов может возникнуть необходимость закрыть свой сайт от индексации поисковыми системами и отображения в результатах поиска. Это может быть полезно во многих случаях, и ниже приведены некоторые причины, по которым это может быть необходимо.

1. Тестирование и разработка

Когда сайт находится в стадии разработки или тестирования, владельцу может понадобиться временно скрыть его от индексации и отображения в результатах поиска. Это позволит избежать нежелательных посещений и индексации незавершенного или неполностью функционального контента. Также это позволит владельцу располагать более гибкой и контролируемой средой для тестирования и настройки сайта.

2. Конфиденциальность и безопасность

В некоторых случаях важно сохранить конфиденциальность определенного контента или функционала сайта, и тогда необходимо закрыть сайт от индексации и отображения в результатах поиска. Это может быть особенно важно для сайтов, содержащих конфиденциальную информацию, личные данные или коммерческие секреты. Такое скрытие помогает предотвратить несанкционированный доступ и уклонение отсканирования такими поисковыми системами, как Google или Яндекс.

3. Подготовка контента и запуск сайта

Закрытие сайта от индексации и отображения в результатах поиска может быть полезно во время подготовки контента и запуска сайта. Это позволяет владельцу контролировать, когда и какой контент будет виден поисковым системам и пользователям. Такой подход может быть полезен при запуске акций, новых продуктов или услуг, чтобы контент был доступен только тогда, когда он будет полностью подготовлен и оптимизирован для показа и продвижения в поисковых системах.

В целом, закрытие сайта от индексации и отображения в результатах поиска является полезным инструментом для контроля и оптимизации контента и функционала сайта. Он позволяет владельцу более гибко управлять процессами тестирования, разработки и запуска сайта, а также обеспечивает безопасность и конфиденциальность важных данных и информации.

Что такое файл robots.txt

В файле robots.txt можно задать правила для поисковых систем. Этот файл позволяет веб-мастерам контролировать поведение поисковых роботов на своем сайте. Он сообщает поисковым системам, какие разделы сайта они могут индексировать, а какие следует игнорировать. Файл robots.txt позволяет также прописывать ссылки на картах сайта (sitemap), которые помогают поисковым системам более эффективно находить и сканировать страницы.

Пример использования файла robots.txt:

User-agent: *

- Disallow: /admin/

- Disallow: /private/

- Disallow: /secret/

- Disallow: /cgi-bin/

В приведенном примере параметр «User-agent: *» указывает, что правило действует для любого поискового робота. Последующие строки с ключевым словом «Disallow:» указывают на запрет доступа к определенным папкам или файлам. В данном случае, роботам будет запрещено индексировать и отображать содержимое папок /admin/, /private/, /secret/ и /cgi-bin/.

Файл robots.txt позволяет веб-мастерам более гибко управлять индексацией и отображением своего сайта в поисковых системах, предотвращать индексацию конфиденциальной информации или временно ограничивать доступ пока сайт находится в разработке.

Как использовать файл robots.txt для закрытия сайта от индексации

Для того чтобы запретить индексацию всего сайта, достаточно добавить в файл robots.txt команду «User-agent: *», которая относится ко всем поисковым роботам, и следующую за ней команду «Disallow: /», которая запрещает доступ ко всем страницам сайта.

Однако необходимо помнить, что файл robots.txt не является средством защиты от взлома или скрытия конфиденциальной информации. Поисковые системы могут проигнорировать указания в файле robots.txt, особенно если информация на сайте является доступной через другие ссылки.

Также стоит помнить, что хотя большинство поисковых систем уважают правила, указанные в файле robots.txt, возможны ошибки, поэтому лучше дополнительно использовать другие методы защиты данных, как например, использование мета-тега «noindex».

Как использовать мета-теги для закрытия сайта от индексации

Если вы хотите, чтобы поисковые системы не индексировали ваш сайт и не отображали его в результатах поиска, вы можете использовать мета-теги для указания этого. Мета-теги это специальные элементы в HTML-коде страницы, которые содержат дополнительную информацию о сайте.

Для того чтобы закрыть сайт от индексации, можно использовать два основных мета-тега: «robots» и «noindex». Тег «robots» используется для указания правил индексации для поисковых роботов, а тег «noindex» говорит поисковым системам, что данная страница не должна индексироваться.

Для того чтобы закрыть сайт от индексации поисковыми системами, вы можете добавить следующую строку кода в секцию

вашего сайта:<meta name="robots" content="noindex">

Этот код сообщает поисковым системам, что данная страница не должна индексироваться. Если вы хотите закрыть от индексации не только данную страницу, но и весь сайт полностью, вы можете добавить еще один тег:

<meta name="robots" content="noindex, nofollow">

Тег «nofollow» говорит поисковым системам, что они не должны следовать по ссылкам на сайте и индексировать страницы, на которые они ведут. Это поможет предотвратить индексацию всех страниц вашего сайта.

Как использовать HTTP заголовки для закрытия сайта от индексации?

Самый простой способ запретить индексацию и отображение сайта — использовать заголовок X-Robots-Tag с указанием директивы noindex, nofollow. Такой заголовок можно добавить в файл .htaccess или настроить веб-сервер, чтобы он автоматически добавлял этот заголовок ко всем страницам вашего сайта.

Если вы хотите запретить индексацию только конкретной страницы, то можно использовать заголовок Robots с указанием директивы noindex, nofollow. Например, для главной страницы сайта добавьте следующий HTTP заголовок:

<meta name="robots" content="noindex, nofollow">

Кроме того, с помощью заголовка X-Robots-Tag можно настроить более гибкие правила для индексации и отображения страниц на вашем сайте. Например, можно указать, что отображение страницы разрешено только посетителям с определенными IP адресами или только для поисковых роботов конкретных поисковых систем.

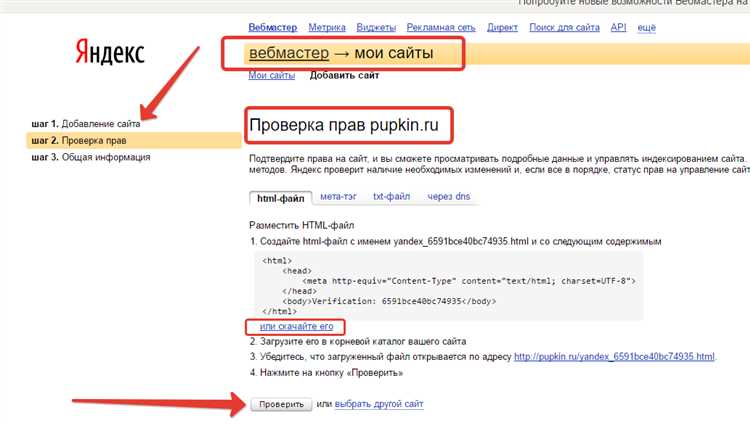

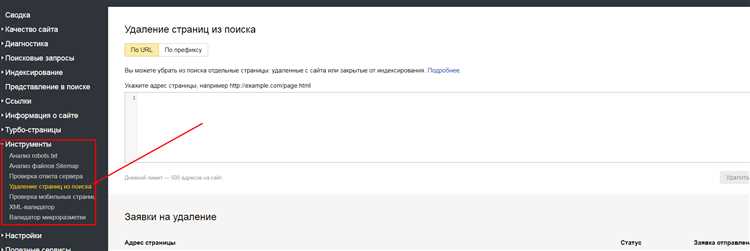

Проверка эффективности закрытия сайта от индексации

После того, как вы применили нужные меры для закрытия сайта от индексации, важно проверить, насколько эффективны они оказались. Для этого можно использовать несколько методов и инструментов.

1. Поисковые системы

Первым шагом для проверки эффективности закрытия сайта от индексации является проверка в поисковых системах. Откройте любую из поисковых систем и введите в поисковую строку адрес вашего сайта. Если поисковая система отображает результаты по вашему сайту, это означает, что закрытие от индексации не удалось. Если же результаты отсутствуют, значит, закрытие прошло успешно.

2. Инструменты поисковой оптимизации

Существуют различные инструменты для проверки эффективности закрытия сайта от индексации. Один из самых популярных инструментов — Google Search Console. Регистрируйтесь в этом инструменте и добавьте ваш сайт. Затем перейдите в раздел «Индексация» и выберите «Покрытие». Здесь вы увидите информацию о том, сколько страниц вашего сайта проиндексировано, и есть ли ошибки или проблемы с закрытием от индексации.

3. Аналитика трафика

Если вы уже используете аналитику трафика на своем сайте, такую как Google Analytics, вы можете использовать этот инструмент для проверки эффективности закрытия от индексации. Если количество органического трафика снизилось после применения мер по закрытию от индексации, это может быть хорошим индикатором успешности ваших действий.

Итак, закрытие сайта от индексации является важной задачей для тех, кто хочет скрыть свой сайт от поисковых систем. При проверке эффективности закрытия следует обращать внимание на результаты поисковых систем, использовать инструменты поисковой оптимизации и аналитику трафика. Проверка позволит вам убедиться, что ваш сайт действительно скрыт от индексации и не отображается в результатах поиска.